MLOps 플랫폼이란?

MLOps 플랫폼 기술은 상용을 위한 기계학습 애플리케이션 배포 및 확장과 관련한 기술이다. 크게 세가지 관점의 기술 내용을 포함합니다.

- ML 모델 상태 관리

- E2E 머신러닝 오케스트레이션

- 컨테이너 기술

ML 모델 상태 관리 기술은 머신러닝 모델의 생명 주기를 관리하고, 모델의 자동 배포 및 모델의 상태 정보를 관리하는 기술입니다. 이를 통해 모델의 생성 일자, 생성 주기, 모델의 성능 수치와 같은 모델의 특성 정보를 포함하여 모델을 모니터링하고, 모델의 사용량 및 처리량을 지속적으로 모니터링하고 제어할 수 있습니다. 이러한 기술은 머신러닝 모델의 생명 주기 관리를 보다 효과적으로 수행하며, 신규 모델을 찾아 해당 모델의 사양을 확인하고 비교할 수 있는 기술을 포함합니다.

E2E 머신러닝 오케스트레이션 기술은 End-to-End 머신러닝 작업의 자동화를 지원하는 기술로, AutoML 기능을 활용하여 AI 모델 생성의 복잡성을 낮춥니다. 이를 통해 사용자는 머신러닝 지식 배경이 없어도 AutoML의 기능을 활용하여 자동화된 모델 생성을 수행할 수 있습니다. 이러한 기술은 머신러닝 작업을 단순화하고 자동화하여 생산성을 높이고, 모델 생성 및 배포의 속도를 빠르게 할 수 있습니다.

컨테이너 기술은 MLOps의 중요 과정들을 컨테이너화하여 솔루션화하고, MLOps 적용 및 운영 과정의 복잡성을 줄이는 기술입니다. 이러한 기술은 머신러닝 모델의 배포 및 운영을 쉽고 빠르게 수행할 수 있게 하며, 모델 개발 및 테스트 환경을 격리하여 보안성을 높일 수 있습니다. 컨테이너 기술을 활용하면 머신러닝 모델의 배포 및 운영 과정에서 발생할 수 있는 문제를 최소화할 수 있으며, 이를 통해 머신러닝 작업의 안정성과 신뢰성을 보장할 수 있습니다.

MLOps 최적화 기술

MLOps 플랫폼 기술은 AI 모델 생명주기를 보다 효율적이고 유연하게 관리하기 위해 최적화 기술 지원이 필요합니다.

- AutoML (Automated Machine Learning)

- 파인튜닝 기술

- GPU 최적화 기술

MLOps는 머신러닝 모델을 효율적으로 관리하고 운영하기 위한 방법론과 기술의 집합입니다. 그 중에서도 AutoML, 파인튜닝, GPU 최적화 기술은 중요한 역할을 담당합니다.

AutoML 기술은 데이터 전처리, 하이퍼파라메터 탐색, 알고리즘 선택 등 머신러닝 과정의 많은 부분을 자동화하여 사용자가 ML 지식이 없더라도 비즈니스 환경에 맞는 최적의 모델을 생성하는데 도움이 됩니다. 이 기술을 보다 솔루션화하여 사용자의 요구에 맞는 최적화된 모델을 생성하는데 활용할 수 있습니다.

파인튜닝 기술은 사전 학습된 언어 모델을 추가로 재학습하여 활용하는 기술입니다. 이를 통해 모델의 정확도를 높일 수 있으며, 정책에 따라 공개할 수 있고 비즈니스 또는 사용자의 요구에 따라 확장이 필요할 수 있습니다. 또한 파인튜닝 기술을 활용하면 모델 운영 비용을 절감할 수 있습니다.

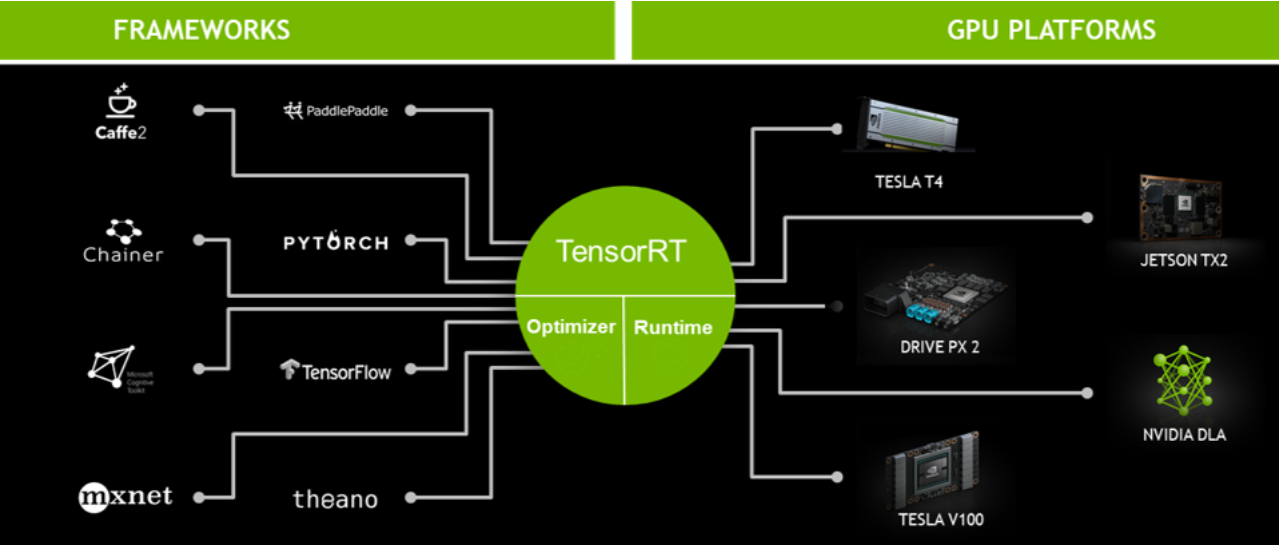

GPU 최적화 기술은 모델 생성에 필요한 GPU 사용량을 효과적으로 관리하여 모델 생성과 운영에 필요한 비용을 줄이는 기술입니다. 하나의 AI 모델을 생성하기 위해서는 많은 GPU 자원이 필요하므로 사용자에게 부담이 될 수 있습니다. 따라서 MLOps 관련 솔루션은 GPU 최적화 기술을 포함하여 적은 GPU 사용량으로도 동등 수준의 AI 모델 생성을 지원할 수 있어야 합니다. NVIDIA/DALI, NVIDIA/TensorRT 등의 기술을 활용하여 GPU 사용량을 최적화할 수 있습니다.

이러한 MLOps 기술들을 적용하면 머신러닝 모델의 생명 주기 전반에 걸쳐 모델을 효율적으로 관리하고 운영할 수 있습니다.

출처 : NVIDIA TensorRT